KAIST, 메모리-중심 인공지능 가속기 시스템 개발

- 가

유민수 교수팀, 최대 21배 빠른 인공지능 기반 알고리즘 기술 개발

지능형 반도체 이용해 메모리 사용량 크게 줄여

(왼쪽부터) 유민수 교수, 권영은 박사과정, 이윤재 석사과정. KAIST 제공

(왼쪽부터) 유민수 교수, 권영은 박사과정, 이윤재 석사과정. KAIST 제공

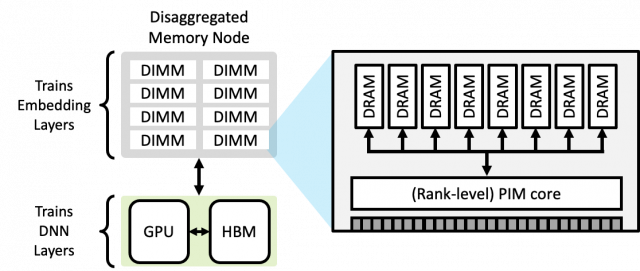

기존 딥러닝 학습 가속기 시스템에 지능형메모리반도체(PIM) 기술을 적용한 가속기 시스템의 모식도. 기존 심층신경망네트워크(DNN) 부분과 임베딩(Embedding)부분을 분리해 각각 그래픽카드(GPU)와 메모리 중심의 지능형메모리반도체 (PIM core)를 이용해 가속하는 시스템으로 구성되어 있다. KAIST 제공

기존 딥러닝 학습 가속기 시스템에 지능형메모리반도체(PIM) 기술을 적용한 가속기 시스템의 모식도. 기존 심층신경망네트워크(DNN) 부분과 임베딩(Embedding)부분을 분리해 각각 그래픽카드(GPU)와 메모리 중심의 지능형메모리반도체 (PIM core)를 이용해 가속하는 시스템으로 구성되어 있다. KAIST 제공

삼성미래기술육성재단이 지원한 한국과학기술원(KAIST) 연구진이 세계 최초로 ‘프로세싱-인-메모리(Processing-In-Memory, 이하 PIM)’ 기술을 기반으로 한 인공지능(AI) 추천시스템 학습 알고리즘 가속에 최적화된 지능형 반도체 시스템 개발에 성공했다.

KAIST(총장 신성철)는 전기·전자공학부 유민수 교수 연구팀이 기존 기술보다 획기적으로 빠른 인공지능(AI) 기반 추천 알고리즘 기술을 개발했다고 16일 밝혔다.

AI 기반 추천 알고리즘 기술은 방대한 양의 콘텐츠를 학습시킨 뒤 사용자에게 맞춤형 추천을 지원하는 시스템이다.

데이터를 '임베딩'(Embedding)이라 불리는 추상화된 형태로 딥러닝(심층학습) 하는 과정을 거쳐 콘텐츠를 추천하거나 개인 맞춤형 광고 등을 제공하게 된다.

하지만 대규모 웹서비스에서는 AI 추천 알고리즘 수행을 위한 메모리 용량이 크게 증가하면서 학습 과정에서 병목 현상이 일어난다.

연구팀은 임베딩 학습 과정에서 수행되는 연산을 단일 연산으로 변환할 수 있는 알고리즘을 개발, 메모리 대역폭 사용량을 크게 줄였다.

데이터를 하드디스크가 아닌 메모리에 저장함으로써 처리 속도를 획기적으로 높일 수 있는 '프로세싱 인 메모리'(PIM) 기술에 기반한 지능형 반도체를 적용했다.

기존 AI 알고리즘 학습에 널리 쓰이는 미국 엔비디아의 그래픽 처리장치(GPU)보다 처리 속도가 최대 21배가량 빠르다고 연구팀은 설명했다.

유민수 교수는 "페이스북 데이터센터에서 처리되는 AI 연산의 70%가 추천 알고리즘을 처리하는 데 사용될 정도로 AI 추천 기술에 대한 수요가 급증하고 있다"며 "이번 연구를 통해 AI 반도체 기술 개발에 기여할 것"이라고 말했다.

송현수 기자 songh@busan.com

송현수 기자 songh@busan.com

당신을 위한 AI 추천 기사

실시간 핫뉴스